Inhoudsopgave van: Maak je website energiezuiniger met deze tips

- Wat is die milieu-impact van websites dan?

- Welke URLs heeft mijn site precies?

- Maar hoe maak je je website groener?

- -- Stap 1: RSS en shortlinks uitzetten

- -- Stap 2: Zorg dat je bijlage attachment page naar de bijlage zelf doorverwijst

- -- Stap 3: Verzoek spider bots niet meer langs te komen

- -- Stap 4: Blokkeer bots echt volledig

- -- Stap 5: De rest :)

- Wat doet ManagedWPhosting voor mijn site?

- Hulp nodig?

- TLDR;

Categorie: Duurzaamheid | Tags: datacenter, duurzaam, energiezuinig, spider bots

Op WordCamp 2022 gaf Joost de Valk, van Yoast, een presentatie over hoe je veel duurzamer kunt zijn met je websites. Ook als het een site is waar maar 5 pagina's op staan en die je nooit voorziet van nieuwe content. De kracht van spider bots is enorm. Wij laten je zien hoe groot precies.

Vermoedelijk denk je: ok, een website, wat heeft dat met het milieu of duurzaamheid te maken? Bedenk dan even dit: je website draait op een server. Die server staat dag en nacht aan en serveert de site(s) aan webbezoekers en spider bots. Dat kost stroom. Veel stroom. En dat stoot in beginstel dus CO2 uit. Het is niet voor niets dat er zoveel tegengeluiden komen als er weer ergens een datacenter gebouwd moet worden. Al die servers bij elkaar gebruiken namelijk gigantische hoeveelheden energie. Dan hebben we het nog niet eens over de grondstoffen die nodig zijn voor de bouw en het onderhoud van een serverpark. Meer over impact van digital op ons klimaat kun je lezen op de site van Theo van der Zee. Nu kunnen eigenaren van servers en serverparken veel doen om alles wat groener en duurzamer te maken (lees ook hoe wij dat doen als 200% groene hostingpartij). Maar jij als website eigenaar kan ook veel doen. En het mooie? Je hoeft er niet voor te kunnen programmeren.

Er zijn miljoenen websites, alleen al in Nederland, die op Nederlandse servers draaien. Al die websites krijgen bezoekers, van echte personen en van bots. Bots gebruiken algoritmes die voor een bepaald doel je hele website doorbladeren en de data terugsturen naar andere servers over de hele wereld. En de meeste bots hoeven eigenlijk helemaal niet op je website te zijn. Want wat heb jij eraan dat je website in een Chinese zoekmachine te vinden is, als de content bedoeld is voor de Nederlandse markt? Precies. Het uitsluiten van zo'n bezoekje aan bots kan al veel verschil maken.

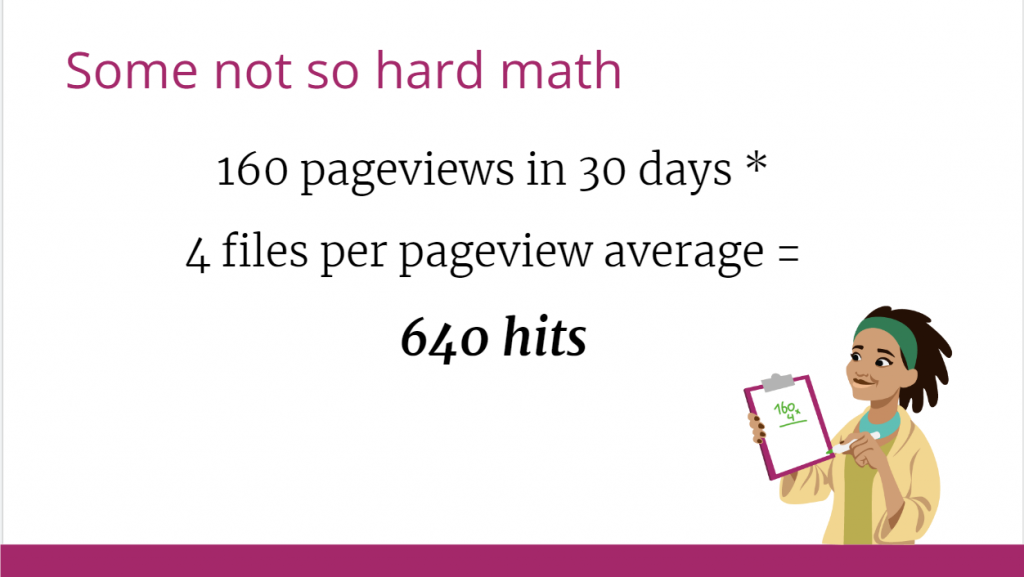

Denk je nu: mijn website is superklein, wat maakt het uit? Hier wat simple wiskunde, van een echte website, overgenomen van de presentatie van Joost. Joost gaat uit van een hele kleine site, met maar 5 pagina's en een enkel (klein) plaatje. Deze site wordt niet actief voorzien van nieuwe inhoud en heeft volgens google analytics 160 pageviews in 30 dagen (steekproef). De site gebruikt cloudflare.

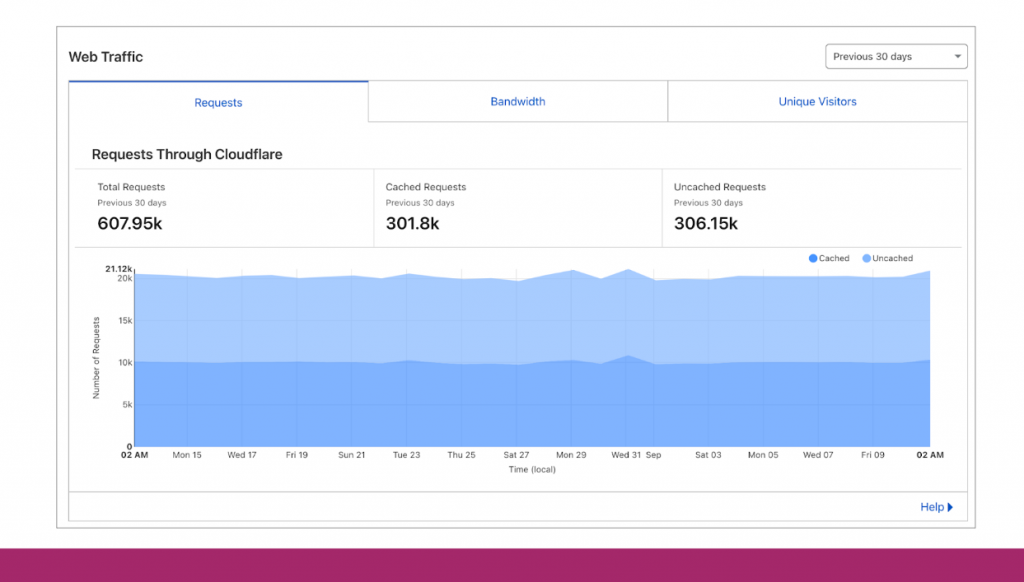

How you think it's going:

How it's really going:

Wat zien we: de site krijgt elke dag heel veel requests en die requests kosten stroom. Er zitten bijna 1000x meer requests op deze site dan we denken. Daar zitten zinvolle requests tussen, zoals die van Google en Bing om de website te indexeren. Maar dat hoeft niet elke dag bij een website die amper wijzigt. Daarnaast zijn er heel veel tools op het web, die websites indexeren voor data, zoals Semrush, Ahrefs en andere SEO-tools. En ook die hoeven niet zo vaak een website te crawlen, als je überhaupt de rest van de wereld al wijzer wilt maken over jouw website. En: ook hackers hebben bots die door websites heen gaan, op zoek naar kwetsbare plekken.

Mocht je denken dat alleen de zichtbare pagina's van je website worden gecrawld (zoals alle linkjes in je navigatiemenu) .. ook dat is niet zo. De bots 'spideren' heel je de server, alles waar ze bij kunnen via de bronbestanden en hints van je website. Dat zijn dus ook afzonderlijke afbeeldingen, ook de scripts, andere mapjes. Tenzij ze actief geblokkeerd worden, reutelen die bots lekker door je mappenstructuur heen. En dan zijn er nog heel veel URL's die je niet meteen ziet, maar er wel zijn, zoals datumarchiefpagina's, auteursarchieven, RSS feeds, URL's die door API's gebruikt worden, etc. In de meeste gevallen zijn die voor normaal functioneren niet eens nodig!

Wat is die milieu-impact van websites dan?

Met 0,005kg per hit, kom je uit bovenstaand voorbeeld al snel op 3080kg CO2 uitstoot. (Noot: deze cijfers hebben we overigens niet verder gecheckt) Deze uitstoot is gelijk aan het absorptievermogen van 141 gewone bomen per jaar. Je kunt het iets gedetailleerder uitrekenen zelf: https://www.websitecarbon.com voor je eigen website. Inclusief hoeveel stroom het ongeveer kost. Zo heeft onze website een geschat stroomverbruik van 102kWh op jaarbasis op basis van het geschatte aantal hits. Wist je al dat wij op groene stroom draaien en servers hergebruiken? Je kunt daar natuurlijk in losgaan en het gewoon letterlijk uitrekenen. Als je weet hoeveel hits je websites hebben en je draait op een eigen server met een eigen stroomrekening en slimme meter, dan is dat een eenvoudig sommetje per hit. Als je dit van heel veel websites bij elkaar optelt, dan begrijp je wel hoe groot het probleem is en waarom datacenters zoveel capaciteit nodig hebben. Daar zou je dus absoluut zelf iets aan moeten doen.

Welke URLs heeft mijn site precies?

Als je uitgaat van 5 pagina's en 30 blogberichten denk je dat je dus 35 URLs hebt. De waarheid is helaas gecompliceerder …

Er zijn namelijk ook nog (met gemak) 60 tag pagina's, 5 categorie pagina's, 30-40 automatische datumpagina's en een auteur archiefpagina. Daar komen nog eens RSS feeds per taxonomie en andere archiefpagina's bij. Tot slot .. elke blogpagina heeft weer een RSS commentaren feed, oEmbed URLs, shortlink ( zoals site.nl?p=15 ) en een REST API link. Tel maar op, je zit zo al snel op een dikke 600 unieke URLS voor een simpele site!

De meeste URLs worden dus automatisch gegenereerd en aan je HTML bron van iedere pagina toegevoegd zodat ze vindbaar zijn voor spider bots en andere automatische tools. Lees verder hoe je dit kunt aanpakken.

Maar hoe maak je je website groener?

In essentie is het zaak om zo min mogelijk URL's te hebben op je website, en er ook naar zo min mogelijk te linken. Dat staat een klein beetje haaks op advies wat vaak van SEO's afkomstig is, maar doe het alleen als het zin heeft voor de bezoeker en de context. Zoekmachines komen er zelf wel uit via je sitemap en menustructuur.

Het makkelijk duurzamer en dus groener maken kun je voor elkaar krijgen op meer dan 1 manier. Wij leggen hieronder uit wat je met de Yoast SEO plugin kunt bereiken, gewoon vanuit je wp-admin beheeromgeving.

Stap 1: RSS en shortlinks uitzetten

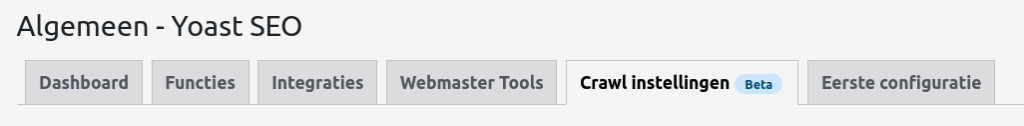

De Yoast Crawl instellingen bij "Algemeen" gaan je enorm blij maken. Schakel de REST API uit als je hem niet gebruikt. Weet je dit niet? Test na uitzetten of je site nog werkt en het sitebeheer ook nog reageert zoals je verwacht.

Op het moment van schrijven kun je er de volgende items mee uitzetten die relevant zijn voor het verminderen van je aantal URLs.

De dikgedrukte items zijn diegenen die wij ook zelf uit hebben staan (dit is vrij behoudend gedaan):

Shortlinks, REST API links, RSD / WLW links, oEmbed links, globale feed ( dit is de RSS feed ), globale reactie feeds ( de RSS voor commentaren ), bericht reactie feeds, bericht auteurs feeds, berichttype feeds, categorie feeds, tag feeds, aangepaste taxonomie feeds ( dit zijn alle extra taxonomieen buiten dus de tags en categorieen ), zoekresultaten feeds, Atom/RDF feeds.

Deze items kun je makkelijk via de Yoast plugin uitzetten, via Algemeen -> Crawl instellingen. Spider bots hebben zo minder URLs die beschikbaar zijn.

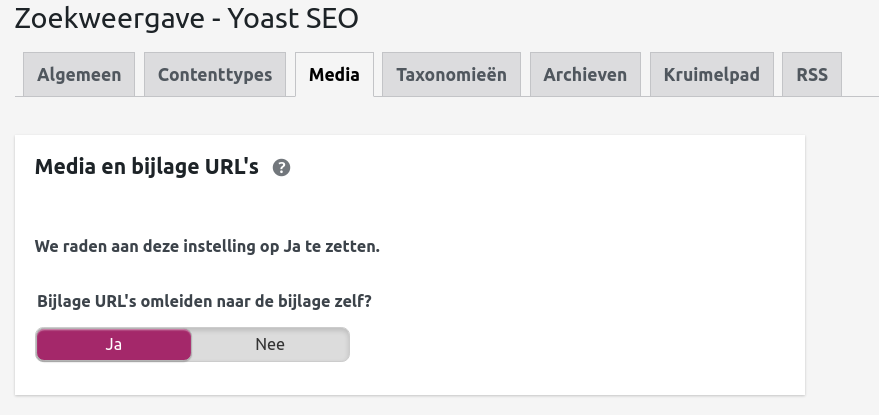

Stap 2: Zorg dat je bijlage attachment page naar de bijlage zelf doorverwijst

Als je een plaatje uploadt, is dat plaatje direct oproepbaar via zijn eigen URL. WordPress maakt er echter een extra media pagina van waarin je bijlage ook te zien is, maar ook de rest van je site. Via Zoekweergave -> Media kun je instellen dat je altijd uitkomt op de eigen URL.

Stap 3: Verzoek spider bots niet meer langs te komen

Verzoek de bots met een Disallow directive via robots.txt (hier ons eigen voorbeeld) niet meer te komen, dit kun je makkelijk via Yoast -> gereedschap doen

Stap 4: Blokkeer bots echt volledig

Als het je lukt, blokkeer bots via .htaccess volledig met een deny op de user-agent (dit is voor geavanceerde gebruikers)

Stap 5: De rest 🙂

- Zorg voor goede canonicals op dubbele pagina's (let op filterpagina's, campagnetagging uit Facebook en Google en pagination)

- Zet 'last modified' in XML sitemaps, meestal staat dit al aan.

- Zoek een hostingpartij die servers heeft draaien op 100% groene stroom en ook slim omgaat met apparatuur (zoals wij dat doen).

- Zorg dat je de laadtijd van je pagina's zo laag mogelijk houdt. Dus geen full raw 8 megapixel plaatjes van je Nikon camera volledig inladen in een blogbericht. Verklein de plaatjes op voorhand. Zie ook de snelheidsblogs op onze site.

- Goede caching (zeker voor websites waarvan de content amper verandert). Daarmee is je site sneller en hoeft de server minder zware calculaties uit te voeren. Hiermee bespaar je stroomkosten en uitstoot.

Wat doet ManagedWPhosting voor mijn site?

Veel! We blokkeren smerige spider bots al voordat ze op jouw webserver komen. Het raden van gebruikersnamen staat ook uit. Dat is een stukje veiligheid en het scheelt weer resources. Caching staat standaard aan en we blokkeren xmlrpc.php al standaard. Ook hebben we steengoede login preventiemaatregelen genomen. Hierdoor komen enkel de legitieme login-pogingen aan op de webserver. De rest blokkeren we al eerder in de keten. En dat spaart weer calculatietijd en dus stroom!

We hebben ook gekozen voor de snellere en veiligere versie van TLS encryptie. Hiermee beveiligen we de lijn tussen de websitebezoeker en onze servers. In plaats van de verouderde RSA/DSA gebruiken wij ECC. Door dit te doen zijn de encryptie uitwisselingen efficienter en dus ook sneller.

Ook niet onbelangrijk: we scannen ook op IP-adres reputatie en ongeschikte woorden als er bijvoorbeeld een commentaar op je site wordt geplaatst. Zo voorkomen we ook hier onnodig rekenwerk en dataverkeer. Wil je weten wat we qua bedrijfsvoering anders aanpakken dan anderen? Lees dan onze MVO pagina.

Hulp nodig?

Het is soms wat technisch. Hoe ziet jouw robots.txt eruit? Wat heb je zelf nog meer gedaan? Meld het via de reacties. Wist je al dat wij 1 uur snelheidsoptimalisatie gratis voor je regelen bij aanschaf van een Business of NVME WooCommerce pakket?

TLDR;

- Je website kost stroom, veel meer dan je denkt. Dat zorgt voor ronkende datacenters, hoge stroomkosten, hoge CO2-uitstoot, verstoring van de natuur, verpest uitzicht van je leefomgeving. Dus maak je website sneller en zorg ervoor dat je site zo klein mogelijk is, met zo min mogelijk URL's en zo min mogelijk hits van bots. Verzoek robots niet meer langs te komen (bekijk hier onze robots.txt en zie hoe we o.a. Baiduspider hebben staan) . Als je wilt weten hoe, had je het moeten lezen. Hier bronnen: https://www.websitecarbon.com/ en presentatie van Yoast.

Deze blog is geschreven in samenwerking met Yoast

Als je dit artikel leuk vond, dan moet je deze speciaal geselecteerde artikelen ook lezen!